Ollama:本地部署大语言模型的利器

在数据安全和隐私保护日益重要的今天,企业及开发者越来越倾向于在本地部署大型语言模型(LLMs)。

Ollama是一款开源工具,专为在本地计算机上快速部署和运行大型语言模型而设计。

Ollama 是什么?

Ollama 是一款开源工具,专注于在本地计算机上快速部署和运行大型语言模型(LLMs),如 Llama 3、DeepSeek-R1 等。其设计理念类似于 Docker,通过命令行即可完成模型的下载、管理和交互,极大降低了非专业用户的使用门槛。Ollama 基于 llama.cpp 开发,继承了其高效推理能力,并在此基础上提供了更加友好的用户界面和更丰富的功能特性。

开发背景

- 隐私与成本需求:随着数据安全意识的增强,企业及开发者更倾向于本地部署模型,避免依赖云端服务带来的隐私泄露和高昂成本。近年来,数据泄露事件频发,如 2021 年某科技公司的数据泄露事件,导致数百万用户信息被窃取,给企业带来了巨大的损失。

- AI 工具普及:开源大模型(如 DeepSeek R1)的流行催生了简化部署工具的需求,Ollama 应运而生。

核心功能与作用

- 模型管理

- 一键运行:通过

ollama run <模型名>命令直接启动模型,支持自动下载和加载。 - 模型库支持:内置 40+ 预训练模型(如 Llama 3、Qwen2),支持自定义模型导入(GGUF/PyTorch 格式)。

- 一键运行:通过

- API 集成

- 提供 REST API,支持通过 HTTP 请求调用模型,便于集成到第三方应用(如代码编辑器、知识库系统)。

- 跨平台兼容支持

- 支持 Windows、macOS、Linux 系统,并可通过 Docker 容器化部署。

- 资源优化

- 支持量化技术(如 4-bit),降低显存占用,8GB 内存设备即可运行 7B 参数模型。

部署指南

1. 安装步骤

- Windows/macOS:官网下载安装包,设置环境变量(如

OLLAMA_MODELS修改模型存储路径)。 - Linux:

# 一键安装

curl -fsSL https://ollama.com/install.sh | sh

# 启动服务

sudo systemctl start ollama

- Docker 部署:

# 映射端口和存储路径

docker run -d -p 11434:11434 -v /path/to/models:/root/.ollama ollama/ollama

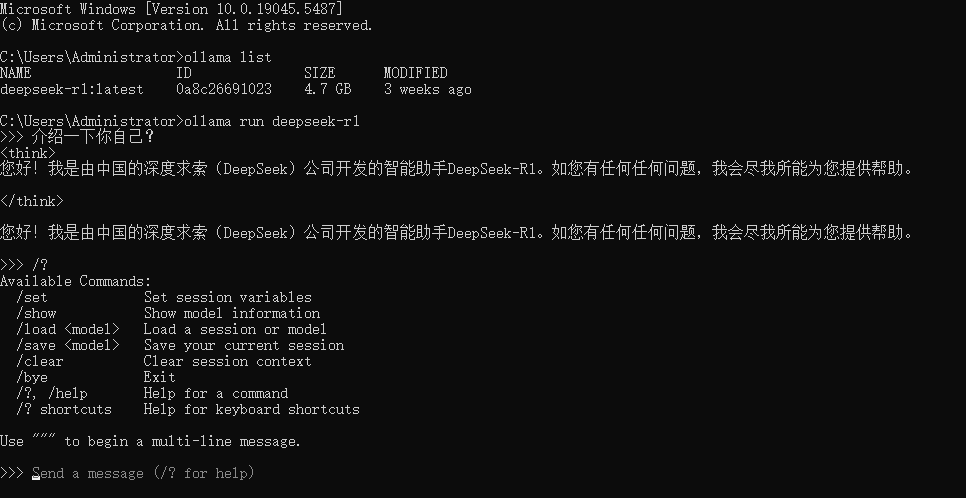

2. 模型运行示例

# 查看可用模型

ollama list

# 下载模型

ollama pull llama3.1

# 查看模型详细信息(参数、停止词等)

ollama show llama3.1

# 启动模型

ollama run llama3.1

# API 调用

curl http://localhost:11434/api/chat -d '{"model": "llama3.1", "messages": [{"role": "user", "content": "你好!"}]}'

3. 注意事项与风险

- 安全隐患

- 未授权访问:默认开放 11434 端口且缺乏鉴权,攻击者可窃取模型或执行恶意代码(如 CVE-2024-37032 远程命令执行漏洞)。

- 插件风险:部分插件(如 ComfyUI)存在代码注入漏洞,需谨慎使用。

- 硬件要求

- 7B 模型需至少 8GB 内存,70B 模型需 24GB+ 显存,低端设备仅支持小型模型。

- 性能限制

- 单卡推理速度低于生产级框架(如 vLLM),且不支持分布式集群。

同类软件对比

| 工具 | 核心定位 | 优势 | 适用场景 |

|---|---|---|---|

| llama.cpp | CPU/边缘推理 | 低资源占用、嵌入式设备兼容 | 无 GPU 环境、量化推理 |

| Ollama | 开发者本地工具 | 操作简单、支持多模型 | 快速测试、隐私敏感场景 |

| LM Studio | 非技术用户桌面应用 | 图形界面、无需编程 | 个人体验、轻量级交互 |

| vLLM | 生产级 GPU 服务 | 高吞吐量、支持分布式 | 企业级 API 服务 |

对比分析:

- 易用性:Ollama 和 LM Studio 适合新手,但 Ollama 的 CLI 灵活性更高。 例如,在实际应用场景中,如果你需要快速测试模型效果,Ollama 的命令行界面会更加方便。

- 性能:vLLM 的 PagedAttention 技术优化显存管理,吞吐量远超 Ollama。 例如,在企业级 API 服务中,vLLM 的性能优势会更加明显。

总结

Ollama 是平衡易用性与隐私保护的本地 LLM 部署工具,适合快速验证模型效果或轻量级开发。若需企业级高并发服务,建议结合 vLLM 或云服务扩展。部署时需注意安全配置(如限制端口访问、定期更新版本),并优先选择社区验证的插件。

Q&A

- 修改其他设备访问权限。

# win10 配置变量

OLLAMA_HOST=0.0.0.0

评论